LyonIX est le nœud d'échange de trafic Internet (IXP - Internet eXchange Point) de Lyon, géré par Rezopole.

LyonIX est également un NAP (Network Access Point), c'est à dire une place de marché pour vendre et acheter du transit Internet et/ou tous types de services IP.

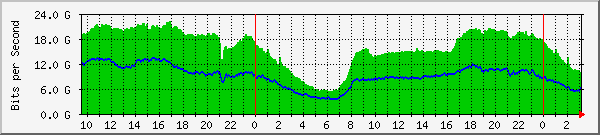

Trafic LyonIX

LyonIX en chiffres

120 sessions BGP

19 baies

6 POPs

252 équipements hébergés

151 ports Ethernet

8,8 Tb/scapacité totale

32fournisseurs sur la place de marché